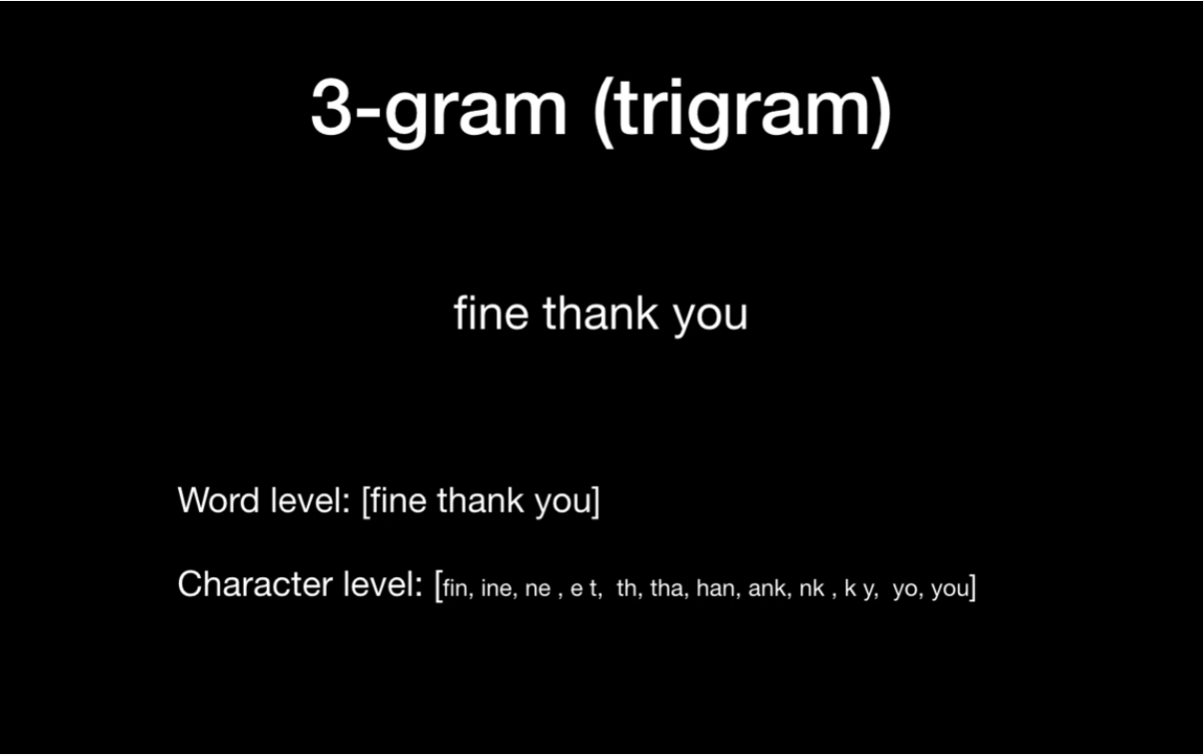

n-gram

연속적으로 n개의 token (words, character, ...)로 이뤄진 것

n-gram을 사용하는 이유

- Overcome the bag of words' drawback : 단어의 순서가 무시된다는 문제 극복

예제 : machine learning is fun and is not boring

bag of word에 위 문장을 넣었을 때 'not'이 어떤 단어에 속하는지 모르게 된다.

- Next word prediction

- Find misspelling

qwal을 입력받게 된다면 qual로 추천해줄 수 있다.

'Deep Learning > NLP' 카테고리의 다른 글

| [NLP] 자연어 유사도 측정 (0) | 2021.07.19 |

|---|---|

| [NLP] TF-IDF (0) | 2021.07.19 |

| [NLP] Bag of words (0) | 2021.07.19 |